DNN

기반의

자체 개발 BERT 기반의 NLU

자체 개발

기반의

기반의

기존 Rule 방식보다 다양한 발화에 대해 유연하게 대처 가능

Intent, Slot-Value보다 더 유연하고 폭이 넓은 Act와 Slot의 조합으로 문장을 분석함

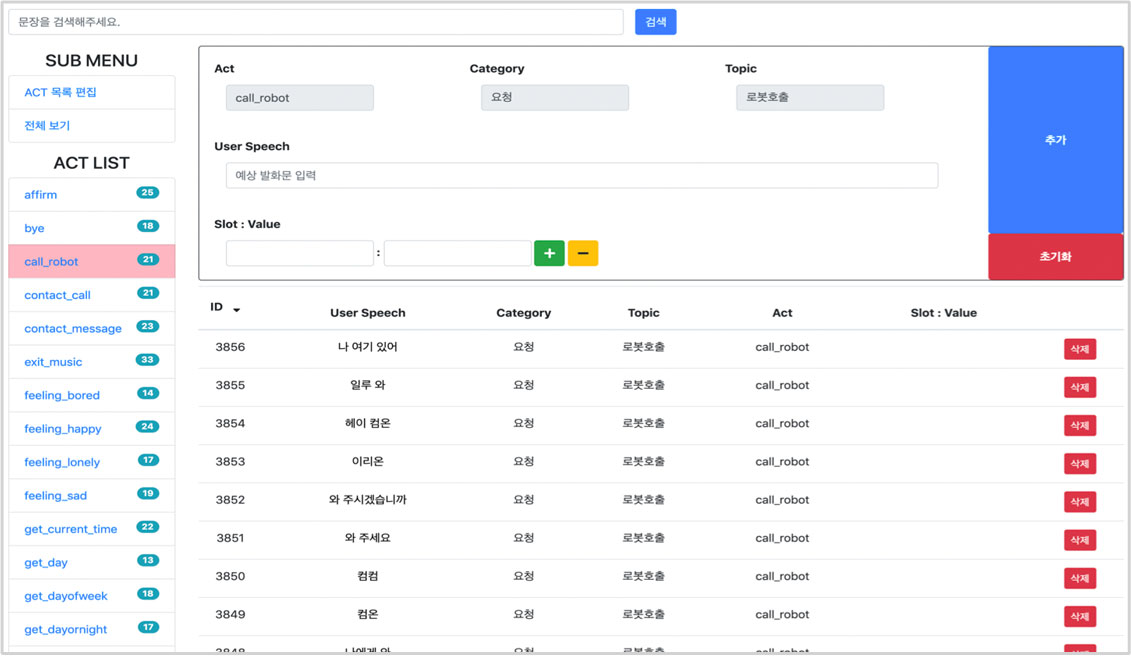

주어진 문장을 Tagging 하기 위한 전문도구를 제공하여 바로 모델학습에 활용할 수 있음

음성대화 또는 챗봇에서 사용자의 의도를 파악하고 의미를 추출하기 위해 한국어 Bert 기반의 NLU를 자체 개발했습니다

한국어 BERT를 훈련하기 위해 Tesla B100 4장 기반의 슈퍼 컴퓨터(Mixed Precision 500 TFLOPS)를 이용하여 2달간 13GB 정도의 텍스트 데이터를 기반으로 모델을 훈련하였습니다.

자사에 보유한 "NLU 데이터 툴"을 이용하여 간단하게 문장을 추가하는 것만으로 모델을 학습하고 사용할 수 있습니다

한국어

기반의

BERT는 Transformer를 이용한 최신 언어모델 학습 기법으로, 언어처리 분야의 대부분의 Task에서 최고의 성능을 보입니다. 방대한 데이터에 의한 높은 성능을 자랑합니다

음성대화 또는 챗봇에서 필요한 기술로, 사용자의 의도를 파악하고 필요한 SLOT 정보를 추출합니다. BERT를 이용한 SLU는 60개 가량의 의도가 있는 로봇대화 테스크에서 90% 이상의 성능을 보장합니다.

intent |

create_schedule |

|---|---|

slot/value |

date : 내일 time : 오전 9시 event_title: 쇼핑 |

* DNN: Deep Neural Network = 딥러닝

* BERT: Bidirectional Encoder Representations from Transformers

=인공지능 기반 언어학습 모델

데이터

관리 도구

· SLU: Spoken Language Understanding=NLU=자연 언어 이해